20.01.2026

Qué es Data Science: la guía para impulsar tu negocio con datos

La ciencia de datos es la disciplina que utiliza métodos científicos, programación y conocimiento de negocio para extraer valor de la información.

Pedro Cailá

Qué es data science (y por qué es mucho más que analizar datos)

El término data science se confunde a menudo con mirar números en una hoja de cálculo. En realidad, es un campo que mezcla estadística, informática y conocimiento del sector para entender el porqué de los resultados.

Su verdadero poder no está en describir lo que ya ha ocurrido, sino en adelantarse a los acontecimientos. Busca patrones ocultos para predecir tendencias y te dice qué palancas mover para mejorar los resultados.

Se diferencia del análisis de datos o la inteligencia de negocio (BI) en su alcance estratégico. Un analista de datos pregunta: "¿Qué pasó el trimestre pasado?". Un científico de datos responde a: "¿Qué pasará el próximo trimestre y qué podemos hacer para que sea mejor?".

La gran diferencia está en la perspectiva. El análisis de datos mira por el retrovisor para generar informes. La ciencia de datos mira por el parabrisas para construir modelos que anticipan el futuro.

Las tres disciplinas de datos, explicadas sin rodeos

Para entender qué es data science, lo mejor es compararlo con sus disciplinas hermanas. Cada una juega un papel distinto y responde a preguntas de negocio diferentes.

- Business Intelligence (BI): Se centra en el pasado y el presente. Usa datos históricos para crear dashboards e informes que muestran el estado actual del negocio. Su pregunta clave es: ¿Qué ha pasado?

- Análisis de Datos (Data Analytics): Va un paso más allá. No solo describe, sino que intenta entender por qué ocurrieron las cosas, buscando tendencias o anomalías. Su pregunta es: ¿Por qué ha pasado?

- Ciencia de Datos (Data Science): Es la disciplina proactiva. Utiliza lo anterior para construir modelos que predicen lo que va a ocurrir y automatizan decisiones para influir en el futuro. Sus preguntas son: ¿Qué pasará? y ¿Qué deberíamos hacer al respecto?

Pensemos en un e-commerce. Un analista de BI informa de que las ventas cayeron un 10% el mes pasado. Un analista de datos investiga y descubre que el problema fue un pico de carritos abandonados.

El científico de datos construye un modelo que predice en tiempo real qué usuarios están a punto de abandonar la compra y les ofrece automáticamente un descuento para que no lo hagan. Es la diferencia entre analizar el problema y solucionarlo antes de que ocurra.

Esta tabla resume las diferencias clave y te ayudará a identificar qué perfil o enfoque necesita tu empresa.

Diferencias clave entre Data Science, Data Analytics y Business Intelligence

Business Intelligence

Objetivo principal: Describir el rendimiento histórico

Tipo de preguntas: ¿Cuáles fueron nuestras ventas mensuales?

Herramientas comunes: Tableau, Power BI, Qlik

Análisis de Datos

Objetivo principal: Entender las causas de los resultados

Tipo de preguntas: ¿Por qué bajaron las ventas en Madrid?

Herramientas comunes: SQL, Excel, Python (Pandas)

Ciencia de Datos

Objetivo principal: Predecir y optimizar resultados futuros

Tipo de preguntas: ¿Qué clientes abandonarán el servicio?

Herramientas comunes: Python (Scikit-learn), R, TensorFlow

La ciencia de datos es una capacidad estratégica que permite a las empresas dejar de reaccionar a los cambios del mercado y empezar a anticiparse a ellos, convirtiendo los datos en una ventaja competitiva tangible.

El proceso de data science en la práctica

Un proyecto de data science es un proceso estructurado que transforma datos brutos en decisiones inteligentes. Es un ciclo en el que a menudo se vuelve a fases anteriores para refinar ideas o mejorar resultados.

Imaginemos una fintech que quiere predecir qué clientes tienen un alto riesgo de impago en sus préstamos. Su equipo seguiría un camino similar a este.

El valor de los datos se construye de forma progresiva. Se analiza el pasado para entender qué ha ocurrido, se diagnostica el presente y, con esa base, se puede predecir e influir en el futuro.

Este flujo visualiza cómo la ciencia de datos convierte la información histórica en una herramienta estratégica para anticipar el futuro.

Fase 1: Adquisición y almacenamiento de datos

El primer paso es conseguir la materia prima. Los datos pueden estar dispersos en distintos sistemas y formatos. La clave es capturarlos y centralizarlos para que el equipo pueda trabajar con ellos.

Las fuentes pueden ser variadas:

- Bases de datos internas: Historial de transacciones de clientes (SQL).

- APIs de terceros: Datos de agencias de crédito o información demográfica.

- Datos de comportamiento: Logs de actividad en la app o web.

- Fuentes no estructuradas: Comentarios de clientes en redes sociales o emails (NoSQL).

Para la fintech, esto implica reunir el historial de pagos de cada cliente, sus datos demográficos, su interacción con la aplicación y su puntuación de crédito externa.

Fase 2: Limpieza y preparación de datos

Esta es la parte menos glamurosa, pero la más importante. Los datos reales son caóticos: desordenados, incompletos y con errores. Alimentar un modelo predictivo con datos de mala calidad produce predicciones inútiles.

El trabajo en esta etapa se centra en:

- Gestionar valores ausentes: Decidir si eliminar registros incompletos o imputar los datos faltantes.

- Corregir inconsistencias: Estandarizar formatos, como fechas o categorías de productos.

- Eliminar duplicados: Asegurar que cada registro sea único para no sesgar el análisis.

- Transformar variables (Feature Engineering): Crear nuevas características a partir de las existentes, como calcular la ratio de deuda sobre ingresos de un cliente.

Para la fintech, esto podría significar corregir DNIs mal escritos, unificar formatos de direcciones y crear variables como "número de pagos atrasados en los últimos 6 meses".

La preparación de datos puede consumir hasta el 80% del tiempo de un proyecto. Invertir bien estas horas separa un modelo que funciona de uno que no.

La adopción de tecnologías como el Big Data mide la madurez de una empresa en este campo. En España, el análisis de Big Data está presente en un 11% de las empresas. El objetivo de la agenda España Digital 2026 es que, para ese año, el 25% de las compañías lo utilicen. Esta tendencia es fundamental para que las startups y scaleups saquen valor de sus datos.

Fase 3: Análisis exploratorio de datos (EDA)

Con los datos limpios, llega el momento de la exploración. El análisis exploratorio (EDA) consiste en utilizar visualizaciones y estadísticas para encontrar patrones, correlaciones entre variables y formular las primeras hipótesis.

Por ejemplo, la fintech podría crear un gráfico para ver la distribución de impagos por comunidad autónoma o edad. Quizás descubran que los clientes más jóvenes con trabajos temporales tienen una tasa de impago mucho más alta. Estos hallazgos guían la siguiente fase.

Fase 4: Modelado y machine learning

Aquí la predicción toma forma. Con las pistas del EDA, se seleccionan, entrenan y evalúan distintos algoritmos de machine learning para encontrar el modelo que mejor prediga la probabilidad de impago de un préstamo.

La fintech podría probar varios modelos:

- Regresión logística: Sencillo y fácil de interpretar.

- Random Forest: Más complejo, pero a menudo más preciso.

- Gradient Boosting: Un algoritmo potente que suele dar excelentes resultados.

El mejor modelo no siempre es el más complicado. Se busca el equilibrio entre precisión, interpretabilidad y coste computacional. Es un proceso de selección riguroso, y en Kulturo sabemos que un buen candidato domina tanto la teoría como la aplicación práctica de estos modelos, algo que detallamos en nuestro enfoque sobre el proceso de selección de perfiles tecnológicos.

Fase 5: Despliegue y monitorización

Un modelo guardado en un portátil no aporta valor. El despliegue (deploy) consiste en integrar el modelo final en el entorno de producción para que empiece a tomar decisiones reales. Para la fintech, esto significa que cada vez que un nuevo cliente pida un préstamo, el modelo calculará su riesgo de impago automáticamente.

El trabajo no termina aquí. Los modelos se degradan con el tiempo porque el comportamiento de los usuarios cambia. Por eso, la monitorización continua es vital para vigilar la precisión del modelo y reentrenarlo con datos nuevos cuando sea necesario, reiniciando así el ciclo.

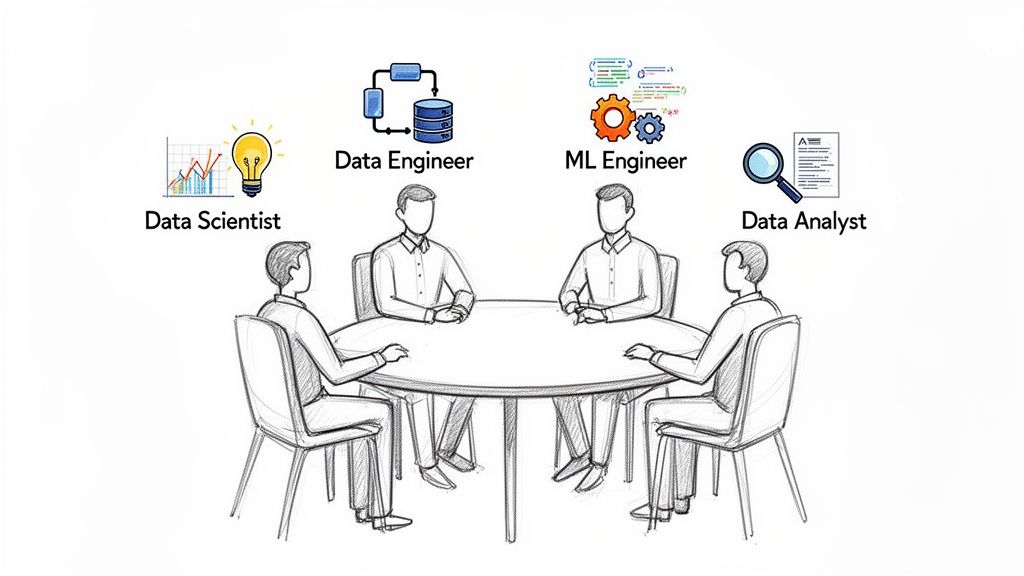

Cómo es un equipo de datos de alto rendimiento

Un equipo de datos de élite es una unidad estratégica diseñada para traducir datos brutos en valor de negocio tangible. Su éxito no se mide por la complejidad de sus algoritmos, sino por cómo interactúan los distintos perfiles para resolver problemas reales de la empresa.

Para entender el data science en la práctica, es fundamental conocer a los jugadores de este equipo y las habilidades que marcan la diferencia.

Los roles clave que construyen el valor

Un equipo de datos funcional es como una cadena de montaje bien engrasada. Cada rol tiene una tarea específica, y si uno falla, el proceso se resiente. Estos son los perfiles fundamentales:

- Data Engineer (Ingeniero de datos)

Es la base sobre la que se construye todo. Diseña, monta y mantiene la infraestructura que recoge, almacena y procesa grandes volúmenes de datos. Construye los pipelines que garantizan que los datos fluyan de forma fiable. Sin ellos, no hay materia prima. - Data Analyst (Analista de datos)

Interpreta datos históricos para responder a preguntas de negocio concretas: ¿por qué cayeron las ventas? ¿qué campaña funcionó mejor? Crea dashboards y reportes que visualizan el rendimiento, traduciendo números en insights para la toma de decisiones. - Data Scientist (Científico de datos)

Va un paso más allá del analista. Usa estadística y machine learning para construir modelos que predicen el futuro. No se limita a describir lo que pasó, sino que anticipa lo que va a pasar, respondiendo a preguntas como "¿qué clientes tienen más riesgo de abandonar nuestro servicio?". - Machine Learning Engineer (Ingeniero de ML)

Es el puente entre el modelo experimental y el producto final. Se especializa en desplegar modelos predictivos en producción a gran escala, asegurando que funcionen de manera robusta, rápida y escalable. Son responsables de que el modelo funcione en el mundo real, 24/7.

Las habilidades que de verdad importan (y que no son solo técnicas)

Tener expertos en Python o SQL no garantiza el éxito. Las habilidades que distinguen a un equipo de datos de alto rendimiento conectan la tecnología con las personas y el negocio.

El mejor científico de datos no es el que domina más algoritmos, sino el que entiende el problema de negocio y entrega soluciones con un impacto medible. La técnica es un medio, no un fin.

Tres habilidades subestimadas son cruciales:

- Data Storytelling: La capacidad de comunicar hallazgos complejos a una audiencia no técnica. Un modelo predictivo es inútil si los directivos no entienden sus implicaciones o no confían en sus resultados. Contar una historia convincente con los datos impulsa a la acción.

- Curiosidad insaciable: Los mejores profesionales no se limitan a responder las preguntas que les hacen. Sienten una curiosidad genuina que les lleva a explorar los datos para hacer las preguntas correctas, desvelando oportunidades de negocio ocultas.

- Mentalidad de producto: Un equipo de élite no entrega análisis aislados. Entrega soluciones que se integran en el producto o en los procesos de la empresa. Piensan en cómo se usarán sus modelos, cómo impactarán al usuario y cómo se mantendrán en el tiempo.

Cómo estructurar tu equipo según tu madurez

La estructura ideal de un equipo de datos cambia según la fase de tu empresa.

- Startup (fase inicial): Se suele empezar con un perfil generalista, a menudo un Data Analyst con capacidades de Data Scientist. Esta persona se encarga de todo, desde la infraestructura básica hasta los primeros dashboards y modelos sencillos.

- Scaleup (en crecimiento): A medida que crecen el volumen de datos y la complejidad, se especializan los roles. Se incorpora un Data Engineer para profesionalizar la infraestructura y se divide el trabajo entre Data Analysts (enfocados en BI) y Data Scientists (enfocados en modelos predictivos). Puedes consultar nuestra guía sobre qué perfil de IA necesita tu equipo.

- Empresa consolidada: Los equipos se vuelven más grandes y especializados. Se incorporan ML Engineers para gestionar el despliegue de modelos a gran escala, junto con roles de liderazgo como el Head of Data para coordinar la estrategia.

El mercado para estos perfiles es muy activo. Los salarios de los data scientists en España reflejan una alta demanda, especialmente en hubs como Madrid y Barcelona. Un perfil junior puede ganar entre 2.000 y 2.400 euros mensuales, mientras que un senior puede superar los 3.800 euros. Para las empresas, esta es una apuesta estratégica que acelera los ingresos a través de la IA aplicada.

Aplicaciones de data science que sí facturan

El Data Science solo tiene sentido cuando se traduce en ingresos. Las startups y scaleups que triunfan invierten en datos para resolver problemas de negocio que impactan directamente en la cuenta de resultados.

A continuación, tres aplicaciones concretas y rentables que demuestran el retorno de esta inversión.

El objetivo es mostrar cómo estas ideas se pueden aplicar en tu producto para generar un crecimiento medible. Cada ejemplo explica el "cómo" y el impacto cuantificable en el negocio.

Personalización para disparar la conversión

Un e-commerce que trata a todos sus clientes por igual pierde dinero. La personalización basada en datos es la herramienta más potente para aumentar la conversión y la retención.

- El problema: Un e-commerce de moda tiene una tasa de conversión estancada en un 1.5%. Los usuarios reciben recomendaciones genéricas que ignoran.

- La solución con Data Science: Se crea un sistema de recomendación que aprende del historial de navegación, compras pasadas y el comportamiento de usuarios similares para generar sugerencias personalizadas en tiempo real.

- El cómo: Se utilizan datos de comportamiento (clics, tiempo en página) y transacciones. Un algoritmo de filtrado colaborativo encuentra perfiles similares para predecir qué le gustará a un usuario.

- El impacto medible: La tasa de conversión sube al 2.1%. Las ventas procedentes de recomendaciones personalizadas suponen un 12% de los ingresos totales. El Lifetime Value (LTV) del cliente aumenta un 20% en seis meses.

-

Optimización de precios dinámicos en un SaaS

En un SaaS, un precio único para todos es una estrategia perdedora. Los precios dinámicos permiten ajustar las tarifas según la demanda, el perfil del cliente o el uso del producto, maximizando los ingresos.

- El problema: Una empresa SaaS de marketing tiene un precio fijo. Sospechan que cobran de menos a los clientes grandes y que su precio es una barrera para las startups.

- La solución con Data Science: Se crea un modelo de segmentación de clientes y una estrategia de precios dinámicos. El modelo agrupa a los clientes en clusters según su uso de la plataforma y datos de la empresa.

- El cómo: Se aplican algoritmos de clustering como K-Means sobre los datos de uso y se enriquecen con perfiles de empresa. A cada segmento se le ofrece un plan de precios optimizado.

- El impacto medible: La empresa lanza tres nuevos planes de precios. El Ingreso Medio por Cuenta (ARPA) aumenta un 18% y el churn (tasa de abandono) se reduce un 15% en el segmento de pymes.

El Data Science convierte la fijación de precios de un acto de fe en una decisión estratégica basada en datos. El objetivo no es cobrar más, es cobrar el precio correcto al cliente correcto.

Detección de fraude para minimizar pérdidas

Para una fintech, el fraude es una amenaza existencial. Los sistemas basados en reglas simples son fáciles de burlar. Los modelos de machine learning aprenden a identificar patrones de fraude complejos que un humano no vería.

- El problema: Una fintech de pagos sufre un aumento de transacciones fraudulentas, generando pérdidas y dañando la confianza de los usuarios. Su sistema manual no es suficiente.

- La solución con Data Science: Se implementa un modelo de detección de anomalías en tiempo real. El sistema analiza cada transacción, le asigna una puntuación de riesgo y bloquea las sospechosas.

- El cómo: El modelo se entrena con un histórico de transacciones, tanto legítimas como fraudulentas. Se usa un algoritmo de clasificación (como Gradient Boosting) que aprende a distinguir patrones sutiles que delatan el fraude.

- El impacto medible: El nuevo modelo reduce las pérdidas por fraude en un 40% en el primer trimestre. Los falsos positivos bajan un 25%, mejorando la experiencia del usuario honesto.

Impacto medible de Data Science por área de negocio

Marketing

Caso de uso de Data Science: Segmentación de clientes, Predicción de LTV

Métrica de impacto (KPI): Aumento del ROI en campañas, Reducción del CAC

Producto

Caso de uso de Data Science: Sistema de recomendación, A/B testing inteligente

Métrica de impacto (KPI): Aumento de la Tasa de Conversión, Incremento del Engagement

Ventas

Caso de uso de Data Science: Lead Scoring predictivo

Métrica de impacto (KPI): Mejora de la Tasa de Cierre, Aumento del ARPA

Operaciones

Caso de uso de Data Science: Optimización de inventario, Detección de fraude

Métrica de impacto (KPI): Reducción de Costes Operativos, Disminución de Pérdidas

Finanzas

Caso de uso de Data Science: Previsión de demanda e ingresos (Forecasting)

Métrica de impacto (KPI): Mejora de la Precisión del Presupuesto, Optimización del Cash Flow

Cada proyecto de Data Science debe tener un KPI de negocio asociado desde el primer día para asegurar que mueve la aguja en los indicadores que importan.

Checklist para contratar a tu primer data scientist

Fichar a tu primer data scientist es una decisión que marca un antes y un después. No contratas a un experto en algoritmos, sino a un socio estratégico que te ayudará a tomar decisiones más inteligentes.

Es fácil dejarse llevar por currículums cargados de tecnicismos o por logros en competiciones teóricas que poco tienen que ver con los problemas de negocio del día a día.

Esta guía es un checklist para fundadores, CTOs y equipos de RRHH que se enfrentan a esta contratación crítica por primera vez, ayudando a evaluar tanto la competencia técnica como el encaje con el negocio.

1. Define primero el problema de negocio

El error más común es empezar la búsqueda con una lista de herramientas como "experto en TensorFlow". La tecnología es un medio, no un fin.

El punto de partida correcto es siempre el problema de negocio que quieres resolver.

- ¿Quieres reducir el abandono de clientes (churn)? Necesitas a alguien experto en modelos de clasificación.

- ¿Buscas optimizar tus campañas de marketing? El perfil ideal dominará la segmentación de clientes.

- ¿Necesitas predecir la demanda de tu producto? La clave es la experiencia en modelos de series temporales (forecasting).

Definir el problema primero cambia el enfoque de la entrevista. En lugar de preguntar por herramientas, preguntarás cómo abordaría tu problema específico. Esto evalúa su capacidad para traducir un reto de negocio en una solución técnica, la habilidad más valiosa de todas.

2. Valida su comunicación con un caso práctico

Un modelo predictivo es inútil si los líderes no entienden sus implicaciones. La capacidad de comunicación con perfiles no técnicos es fundamental.

Prepara un caso práctico y pide al candidato que explique sus conclusiones como si las presentara al CEO.

- El reto: "Hemos creado un modelo que predice qué clientes van a darse de baja. Estos son los resultados. Explícame qué significan y qué tres acciones deberíamos tomar".

Aquí no evalúas la precisión del modelo, sino su habilidad para contar una historia con los datos. Fíjate si evita la jerga, se centra en el impacto para el negocio y si sus recomendaciones son claras y accionables.

Un buen data scientist no habla de "curvas ROC" o "precisión F1". Habla de cuántos euros puede ahorrar la empresa o en qué porcentaje pueden aumentar los ingresos.

3. Comprueba su experiencia en el ciclo completo

Muchos candidatos impresionan por haber ganado competiciones en plataformas como Kaggle. Esto demuestra habilidad para el modelado, pero el trabajo real es más amplio y caótico. Un proyecto no empieza con un archivo CSV limpio, sino con el desorden de los datos reales.

Asegúrate de que el candidato tenga experiencia en todo el ciclo de vida:

- Extracción de datos: ¿Ha trabajado con APIs o con queries complejas a bases de datos?

- Limpieza y preparación: Pídele que te cuente cómo resolvió un problema con datos incompletos o inconsistentes.

- Despliegue (Deploy): ¿Ha puesto algún modelo en producción? ¿Sabe lo que implica mantenerlo y monitorizarlo?

Un candidato con experiencia solo en entornos académicos puede tener dificultades para aportar valor en una startup, donde la velocidad y la gestión de la incertidumbre son clave. Para mejorar tu enfoque, aquí tienes consejos sobre cómo optimizar tus procesos de selección técnicos.

4. Evalúa su encaje cultural y autonomía

El encaje cultural es tan importante como la competencia técnica, especialmente en equipos pequeños.

- Autonomía vs. Estructura: ¿Necesita directrices claras o es proactivo y explora los datos por su cuenta? En una startup, la segunda opción es oro.

- Curiosidad y pragmatismo: ¿Te hace preguntas sobre el negocio? ¿Intenta entender a tus clientes? El mejor candidato muestra una curiosidad genuina y entiende que la solución técnica "perfecta" no siempre es la mejor para el negocio.

Encontrar este perfil es un desafío. El mercado laboral de Data Science en España muestra una escasez de talento. Los roles en analítica crecen un 218% interanual, mientras que la oferta de profesionales solo aumenta un 12%. Esto deja al 70% de las empresas sin poder cubrir sus vacantes. Para las scaleups, esta brecha es una oportunidad de diferenciación si consiguen atraer al talento adecuado, como puedes ver en este análisis del mercado de talento tech.

Contar con un socio de recruiting como Kulturo, que entiende estas necesidades, puede marcar la diferencia. Validamos a cada candidato para asegurar que encaja técnica y culturalmente, garantizando una contratación de alto impacto.

Dudas frecuentes sobre data science

A continuación, respondemos a las dudas más comunes que tienen los líderes de negocio sobre el mundo de los datos, con respuestas directas y prácticas.

¿Necesito un data scientist o un data analyst para empezar?

La respuesta depende de tu necesidad actual. No se trata de qué perfil es “mejor”, sino de cuál soluciona tu problema de hoy.

Si tu principal reto es entender qué ha pasado, crear dashboards para seguir KPIs y analizar ventas pasadas, buscas un Data Analyst. Su trabajo es mirar hacia atrás para explicar el presente.

Si quieres predecir qué va a pasar, anticiparte a las necesidades de tus clientes o automatizar decisiones, necesitas un Data Scientist. Su enfoque es mirar hacia adelante para construir el futuro.

Para una startup que busca una ventaja competitiva, el Data Scientist aporta un valor más estratégico a largo plazo. El analista te da el mapa de dónde has estado; el científico te ayuda a dibujar el mapa de adónde vas.

¿Qué herramientas de data science son imprescindibles en una startup?

La tecnología es secundaria al problema. Para una startup, lo más inteligente es empezar con un conjunto de herramientas flexible, de bajo coste y escalable.

Un stack inicial eficiente suele ser:

- Lenguaje de programación: Python es el estándar, con librerías como Pandas, Scikit-learn y Matplotlib/Seaborn.

- Acceso a datos: SQL sigue siendo el rey para consultar bases de datos.

- Infraestructura: Una plataforma en la nube como AWS, Google Cloud Platform (GCP) o Azure es fundamental.

- Visualización y reporting: Herramientas como Tableau, Power BI o soluciones open-source como Metabase son clave para compartir hallazgos.

-

La clave no es tener la herramienta más nueva, sino la que mejor encaja con tu equipo y tu problema.

¿Cuánto tarda un proyecto de data science en dar resultados?

Esperar un retorno de la inversión inmediato es un error común. Un proyecto de data science es un proceso de descubrimiento y prueba.

Un primer modelo funcional, o MVP (Producto Mínimo Viable), puede tardar entre 4 y 12 semanas en estar listo, dependiendo de la calidad y accesibilidad de tus datos.

La mejor estrategia es aplicar una mentalidad ágil: empezar con un objetivo pequeño y concreto, iterar en ciclos cortos, demostrar valor rápido y ajustar el rumbo sobre la marcha. La comunicación constante entre el equipo de datos y el resto del negocio es fundamental para gestionar expectativas.

¿Cómo puedo medir el ROI de mi equipo de data science?

El impacto del data science debe ser medible. El ROI se calcula vinculando cada proyecto a una métrica clave de negocio (KPI) antes de escribir la primera línea de código.

Si el proyecto no mueve una aguja importante para el negocio, no debería ser una prioridad.

Ejemplos concretos de cómo se mide:

- Reducción del churn: Compara el dinero ahorrado al retener clientes con el coste del equipo y la infraestructura.

- Aumento de ingresos: Mide el incremento en ventas que proviene directamente de las sugerencias de un sistema de recomendación.

- Optimización de costes: Calcula el ahorro en costes de almacén gracias a un modelo de gestión de inventario.

Definir estos KPIs desde el principio no solo justifica la inversión, sino que enfoca al equipo en generar un impacto tangible en la cuenta de resultados.

En Kulturo, sabemos que encontrar el talento adecuado para liderar estas iniciativas es el mayor desafío. Nos especializamos en conectar empresas tecnológicas con perfiles de datos que no solo dominan la técnica, sino que entienden cómo generar valor de negocio. Descubre cómo podemos ayudarte a construir tu equipo de datos de alto rendimiento.